人工智能安全測試評價體系及風險知識庫發布 筑牢基礎軟件安全防線

隨著人工智能技術在各行各業的深度融合與應用,其安全問題日益凸顯,成為制約技術健康、可持續發展的關鍵瓶頸。聚焦于人工智能基礎軟件開發領域的重要安全舉措——人工智能安全測試評價體系及風險知識庫正式發布,標志著我國在構建系統化、標準化、可操作的人工智能安全治理框架方面邁出了堅實一步。

體系構建:為AI基礎軟件設立“安全標尺”

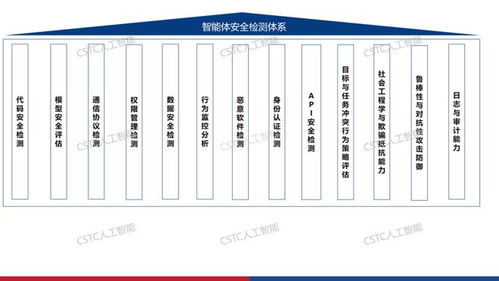

此次發布的人工智能安全測試評價體系,并非簡單的漏洞掃描清單,而是一套覆蓋人工智能基礎軟件全生命周期的綜合性安全框架。該體系主要圍繞以下幾個核心維度構建:

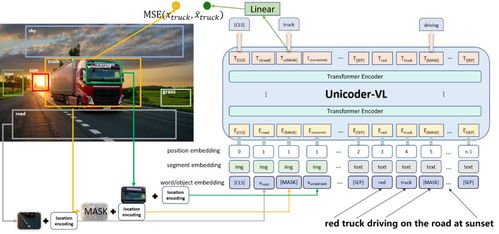

- 數據安全與隱私保護:針對訓練數據、微調數據及推理輸入數據,建立了數據來源合規性、數據質量、隱私泄露風險(如成員推斷攻擊、模型逆向攻擊)、數據投毒檢測等多層次評價指標。

- 模型安全與魯棒性:系統評估模型在面對對抗樣本攻擊、后門攻擊、模型竊取、功能濫用等威脅時的抵御能力。體系明確了模型在噪聲干擾、輸入擾動下的行為穩定性標準。

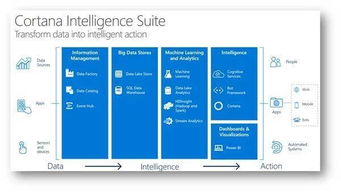

- 系統與平臺安全:涵蓋AI開發框架、算力平臺、部署環境的基礎設施安全,包括訪問控制、供應鏈安全(第三方庫依賴)、容器與運行時安全、API接口安全等。

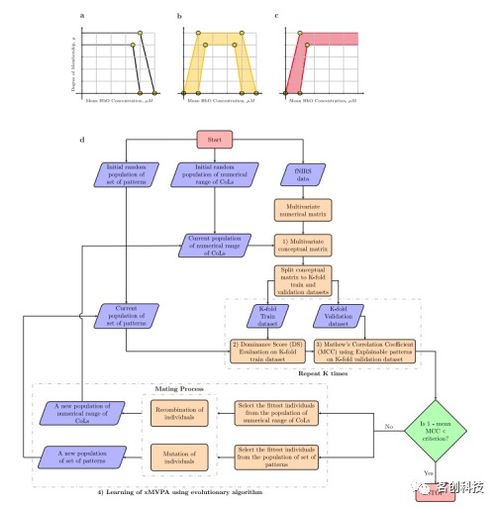

- 算法公平性與可解釋性:致力于檢測和消除算法因數據偏見導致的歧視性輸出,并推動模型決策過程的透明與可追溯,確保技術的負責任應用。

- 全流程安全管理:從需求設計、開發編碼、測試驗證到部署運營、迭代退役,體系將安全要求嵌入每一個環節,推動安全左移,實現“安全內置”。

這套體系為AI基礎軟件的開發者、測試者和采購方提供了一套清晰的“安全標尺”,使得安全能力從難以衡量的抽象概念,轉變為可測試、可度量、可改進的具體指標。

知識庫賦能:匯聚風險智慧,實現主動防御

與測試評價體系相輔相成的是同步發布的人工智能風險知識庫。該知識庫是一個動態演進、持續更新的“安全大腦”,其核心價值在于:

- 風險案例聚合:系統收集、整理、分析了全球范圍內已公開的AI安全事件、漏洞報告、攻擊手法(如Prompt注入、越獄攻擊)和防御實踐,形成了結構化的知識圖譜。

- 漏洞與威脅情報:對AI特有漏洞(如模型文件篡改、特定API濫用)進行統一編碼、分類和嚴重性評級,提供及時的威脅預警和修復建議。

- 最佳實踐指南:提煉了在數據清洗、對抗訓練、安全編碼、隱私計算(如聯邦學習、差分隱私)等方面的有效安全開發模式與工具鏈。

- 標準與法規映射:將技術風險與國內外相關的法律法規、標準規范(如GDPR、中國的《生成式人工智能服務管理暫行辦法》)進行關聯,幫助開發主體滿足合規要求。

風險知識庫的建立,改變了以往AI安全依賴個人經驗與零散信息的局面,使得開發團隊能夠“站在巨人的肩膀上”,提前預見風險模式,將被動響應轉化為主動、預防性的安全設計。

對AI基礎軟件開發的深遠影響

兩者的聯合發布,對人工智能基礎軟件開發領域產生了立竿見影且影響深遠的推動作用:

提升了開發門檻與質量基線。 安全從“可選增值項”變為“必選項”,促使所有基礎軟件(如深度學習框架、模型庫、開發平臺)的提供商必須將安全能力作為核心競爭力的組成部分進行建設。

降低了安全技術壁壘。 體系化的指南和知識庫為廣大的AI應用開發者,特別是中小團隊,提供了可落地的安全工具箱,使他們無需從零開始研究復雜的安全攻防,能夠更專注于業務創新。

再次,促進了生態互信與協同。 統一的測試評價標準有助于形成業界公認的安全認證,提升上下游之間(如框架廠商-模型開發者-應用集成商)的信任度,推動形成更健康、更安全的AI軟件供應鏈。

支撐了監管與治理落地。 這套技術性框架為行業監管提供了科學、細致的參考依據,使原則性的安全要求能夠轉化為可核查的技術動作,助力實現“敏捷治理”。

展望:持續演進,共筑可信AI未來

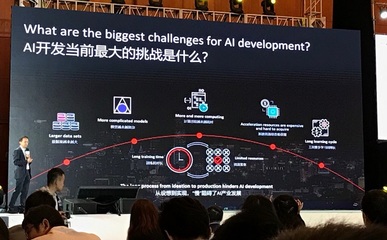

人工智能安全是一場持久戰。此次發布的測試評價體系與風險知識庫是一個重要的起點,而非終點。它們需要隨著AI技術的快速演進(如大模型、具身智能)和攻擊手法的不斷翻新而持續迭代更新。需要產學研用各方廣泛參與,貢獻案例、驗證方法、完善工具,共同將這一體系鍛造得更加堅實、全面。

人工智能安全測試評價體系及風險知識庫的發布,為我國乃至全球的人工智能基礎軟件構筑了一道至關重要的“安全防火墻”。它通過標準化引領和知識共享,從源頭夯實AI安全根基,對于推動人工智能技術安全、可靠、可控地服務于經濟社會高質量發展具有里程碑式的意義。

如若轉載,請注明出處:http://m.hualeqipai.cn/product/46.html

更新時間:2026-02-20 19:03:11